谷歌 DeepMind 今日發(fā)布博客文章,宣布推出一種全新的 Gemini Robotics On-Device 本地化機(jī)器人 AI 模型。

該模型基于視覺(jué)-語(yǔ)言-動(dòng)作(VLA)架構(gòu),無(wú)需云端支持即可實(shí)現(xiàn)實(shí)體機(jī)器人控制。核心特性包括:

技術(shù)能力:

獨(dú)立運(yùn)行于機(jī)器人設(shè)備,支持低延遲響應(yīng)(IT之家注:適用于網(wǎng)絡(luò)不穩(wěn)定場(chǎng)景,如醫(yī)療環(huán)境)

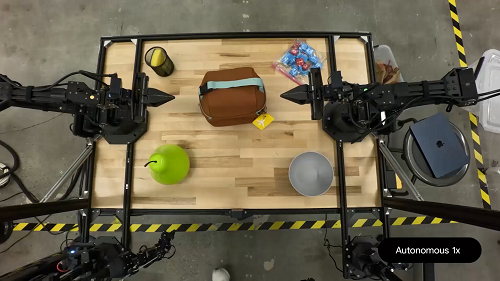

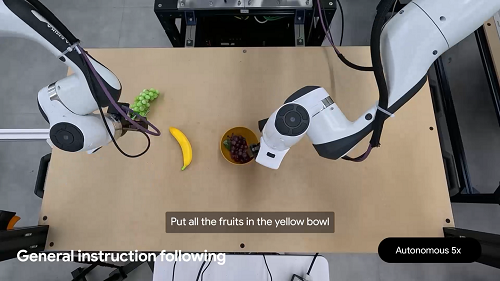

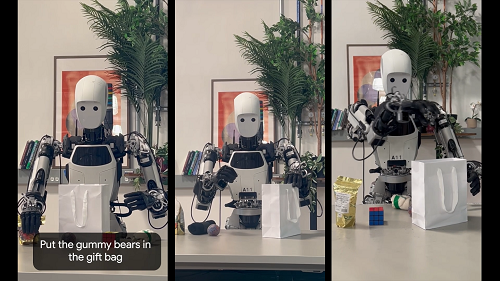

完成高精度操作任務(wù)(如打開(kāi)包袋拉鏈、疊衣服、系鞋帶)

雙機(jī)械臂設(shè)計(jì),適配 ALOHA、Franka FR3 及 Apollo 人形機(jī)器人

開(kāi)發(fā)適配:

提供 Gemini Robotics SDK 工具包

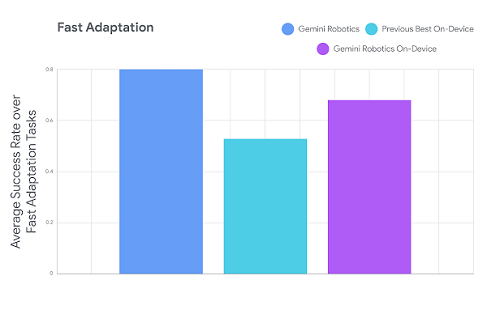

開(kāi)發(fā)者通過(guò) 50-100 次任務(wù)演示即可定制新功能

支持 MuJoCo 物理模擬器測(cè)試

安全保障:

通過(guò) Live API 實(shí)施語(yǔ)義安全檢測(cè)

底層安全控制器管理動(dòng)作力度與速度

開(kāi)放語(yǔ)義安全基準(zhǔn)測(cè)試框架

項(xiàng)目負(fù)責(zé)人 Carolina Parada 表示:“該系統(tǒng)借鑒 Gemini 多模態(tài)世界理解能力,如同 Gemini 生成文本 / 代碼 / 圖像那樣生成機(jī)器人動(dòng)作”。

谷歌表示,該模型現(xiàn)在只面向可信測(cè)試計(jì)劃開(kāi)發(fā)者開(kāi)放,基于 Gemini 2.0 架構(gòu)開(kāi)發(fā)(落后于 Gemini 2.5 最新版本)。