7月23日,美國人工智能初創(chuàng)企業(yè)xAI CEO埃隆·馬斯克(Elon Musk)宣布,xAI 計(jì)劃在未來五年內(nèi)部署相當(dāng)于5,000萬個(gè)英偉達(dá)(NVIDIA)H100 等級的AI GPU,這一目標(biāo)不僅在規(guī)模上超越當(dāng)前的AI 硬件標(biāo)準(zhǔn),還將在能效上有顯著提升。

50 ExaFLOPS 用于 AI 訓(xùn)練

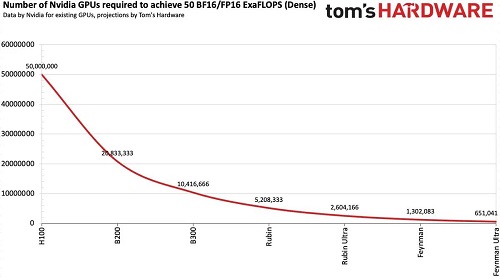

雖然5000萬個(gè)英偉達(dá)H100的數(shù)量看起來很多,但考慮到這里指的是“等效算力”,這也意味著如果xAI未來五年持續(xù)采用最先進(jìn)的GPU,可能只需要不到100萬個(gè)左右就能夠?qū)崿F(xiàn)。

目前一個(gè)英偉達(dá)H100 GPU 可以為 AI 訓(xùn)練提供大約 1,000 FP16/BF16 TFLOPS(這些是目前最流行的 AI 訓(xùn)練數(shù)據(jù)格式),因此到 2030 年,5000 萬臺此類 AI 加速器將需要提供 50 個(gè) FP16/BF16 ExaFLOPS算力用于 AI 訓(xùn)練。根據(jù)當(dāng)前的性能改進(jìn)趨勢,這在未來五年內(nèi)是可以實(shí)現(xiàn)的。

需要65萬個(gè)Feynman Ultra GPU

假設(shè)英偉達(dá)(或其他AI芯片公司)將繼續(xù)以略慢于 Hopper 和 Blackwell 的升級速度擴(kuò)展其 GPU 的 BF16/FP16 訓(xùn)練性能,那么預(yù)計(jì)到 2028 年將使用 130 萬個(gè) 最新的GPU 或 2029 年使用 65萬個(gè)最新的GPU。

如果 xAI 有足夠的錢花在英偉達(dá)最新的AI芯片上,甚至有可能更早實(shí)現(xiàn)部署 50 ExaFLOPS 的AI算力的目標(biāo)。

目前馬斯克 的 xAI 已經(jīng)部署最新 AI GPU 加速器,以提高該公司的AI訓(xùn)練能力,其 Colossus 1 超級集群使用了 200,000 個(gè)基于 Hopper 架構(gòu)的英偉達(dá)H100 和 H200 加速器,以及 30,000 個(gè)基于 Blackwell 架構(gòu)的 GB200 加速器。

此外,xAI接下來的目標(biāo)是構(gòu)建由 550,000 個(gè) GB200 和 GB300 節(jié)點(diǎn)組成的 Colossus 2 集群(每個(gè)節(jié)點(diǎn)都有兩個(gè) GPU,因此該集群將配備超過 100 萬個(gè) GPU)。據(jù)馬斯克透露,第一批節(jié)點(diǎn)將在未來幾周內(nèi)上線。

性能穩(wěn)定提升

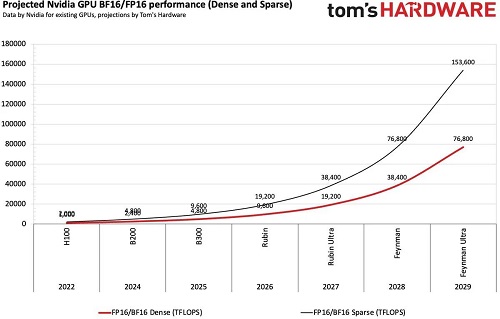

英偉達(dá)(和其他公司)新的 AI 加速器的更新節(jié)奏現(xiàn)在轉(zhuǎn)向了每年一更新,而具體產(chǎn)品的性能升級幅度類似于英特爾過去的 Tick-Tock 模型,即一年小升級,一年大升級。例如,Blackwell后續(xù)是Blackwell Ultra,再接下來是Rubin,后續(xù)是Rubin Ultra。

這種方法確保了每年性能的顯著提高,從而確保了長期性能的顯著提升。例如,英偉達(dá)聲稱其Blackwell B200的推理性能比2016年P(guān)ascal P100高出了20000倍,提供約20000個(gè)FP4 TFLOPS性能,而P100的性能只有19個(gè)FP16 TFLOPS。雖然不是直接比較,但該指標(biāo)與推理任務(wù)相關(guān)。當(dāng)以每生成一個(gè)Token的焦耳數(shù)來衡量時(shí),Blackwell的能源效率也是Pascal的42500倍。

事實(shí)上,英偉達(dá)和其他公司并沒有隨著性能的持續(xù)提高而放緩性能提高的速度。例如,Blackwell Ultra架構(gòu)(B300系列)在人工智能推理方面的FP4性能(15 FPLOPS)比原始Blackwell GPU(10 FPLOPS)高出50%,在人工智能訓(xùn)練方面的BF16和TF32格式性能高出兩倍,但I(xiàn)NT8、FP32和FP64性能較低。作為參考,BF16和FP16是用于AI訓(xùn)練的典型數(shù)據(jù)格式(盡管FP8似乎也經(jīng)過了評估),因此可以合理地預(yù)期英偉達(dá)將通過其下一代Rubin、Rubin Ultra、Feynman和Feynman Ultra GPU來提高這些數(shù)據(jù)格式的性能。

根據(jù)計(jì)算,英偉達(dá)H100的FP16/BF16的性能相比A100提高了3.2倍,然后B200相比H100性能又提高了2.4倍。當(dāng)然,實(shí)際的訓(xùn)練性能不僅取決于新GPU的純數(shù)學(xué)性能,還取決于內(nèi)存帶寬、模型大小、并行性(軟件優(yōu)化和互連性能)以及FP32的累積使用。然而,可以肯定地說,英偉達(dá)可以通過每一代新一代的GPU將其訓(xùn)練性能(FP16/BF16格式)提高一倍。

假設(shè)英偉達(dá)可以通過基于Rubin和下一代的Feynman架構(gòu)的四代后續(xù)AI加速器實(shí)現(xiàn)上述性能提升,那么在2029年的某個(gè)時(shí)候,大約需要65萬個(gè)Feynman Ultra GPU才能達(dá)到大約50個(gè)BF16/FP16 ExaFLOPS。

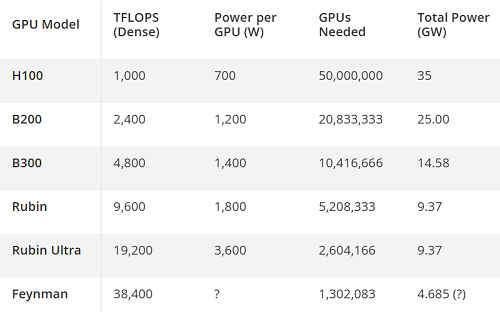

耗電量巨大

盡管馬斯克的xAI和其他人工智能領(lǐng)導(dǎo)者可能會(huì)在未來四五年內(nèi)獲得50 BF16/FP16 ExaFLOPS用于人工智能訓(xùn)練,但最大的問題是這樣一個(gè)超級AI集群將消耗多少電力?

一個(gè)H100 AI加速器功耗大約700W,因此其中5000萬個(gè)處理器將消耗35吉瓦(GW),相當(dāng)于35座核電站的典型發(fā)電量,這使得今天為如此龐大的數(shù)據(jù)中心供電變得不現(xiàn)實(shí)。即使是Rubin Ultra的集群也需要大約9.37吉瓦的電力。假設(shè)Feynman架構(gòu)使BF16/FP16的每瓦性能比Robin架構(gòu)翻了一番,一個(gè)50 ExaFLOPS集群仍將需要4.685 GW的電力,這遠(yuǎn)遠(yuǎn)超過了xAI的Colossus 2數(shù)據(jù)中心所需的1.4 GW-1.96 GW。這一需求將對美國當(dāng)前的能源基礎(chǔ)設(shè)施提出嚴(yán)峻的挑戰(zhàn)。