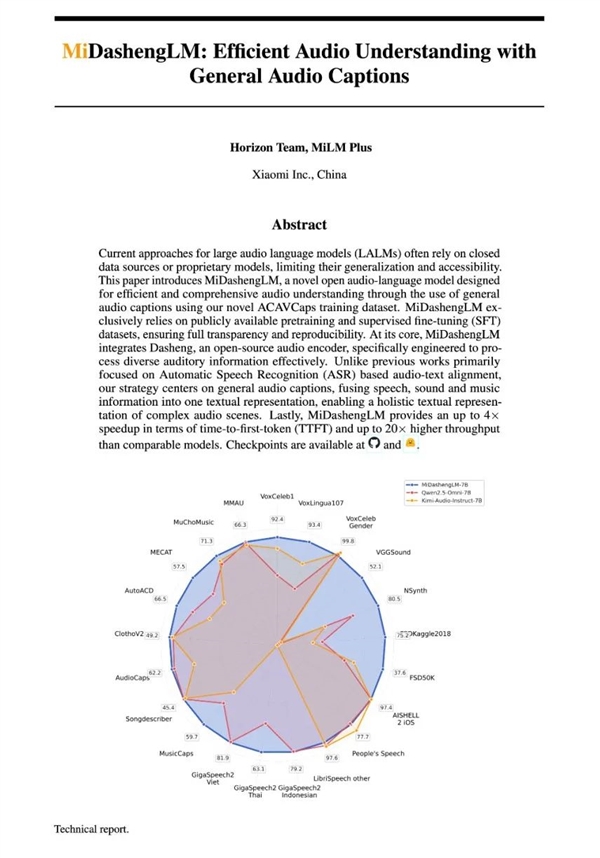

8月4日消息,小米正式發布并開源聲音理解大模型MiDashengLM-7B,該模型是小米“人車家全生態”戰略的關鍵技術組件。

MiDashengLM通過統一理解語音、環境聲與音樂的跨領域能力,不僅能聽懂用戶周圍發生了什么事情,還能分析發現這些事情的隱藏含義,提高用戶場景理解的泛化性。

基于MiDashengLM的模型通過自然語言和用戶交互,為用戶提更人性化的溝通和反饋,比如在用戶練習唱歌或練習外語時提供發音反饋并制定針對性提升方案,又比如在用戶駕駛車輛時實時對用戶關于環境聲音的提問做出解答,其應用場景有廣闊的空間。

結合高效的推理部署性能,MiDashengLM將廣泛賦能智能座艙、智能家居等場景,推動多模態交互體驗升級。

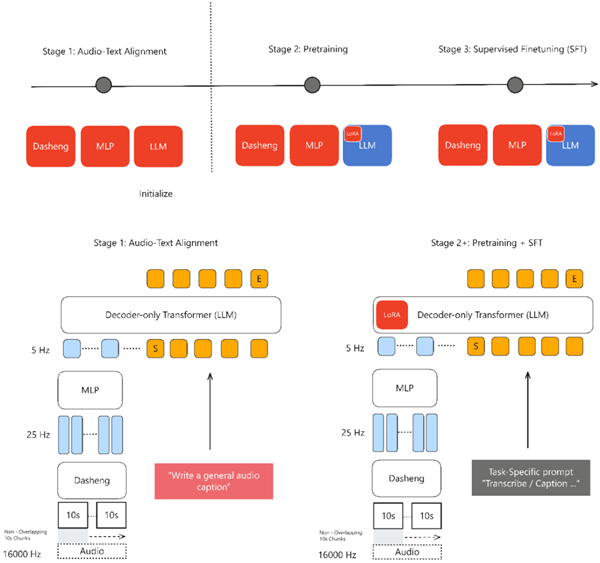

基于Xiaomi Dasheng音頻編碼器和Qwen2.5-Omni-7B Thinker自回歸解碼器構建,通過通用音頻描述訓練策略,實現對語音、環境聲音和音樂的統一理解。

訓練數據100%來自公開數據集,涵蓋五大類110萬小時資源,以Apache License 2.0協議發布,支持學術和商業應用。

核心優勢:

性能領先:在22個公開評測集上刷新多模態大模型最好成績(SOTA),在音頻描述、聲音理解、音頻問答任務中表現突出,同時具備可用的語音識別能力。其音頻編碼器Xiaomi Dasheng在X-ARES Benchmark多項關鍵任務,尤其是非語音類理解任務上顯著優于Whisper。

推理效率高:單樣本推理的首Token延遲(TTFT)僅為業界先進模型的1/4;同等顯存下數據吞吐效率是業界先進模型的20倍以上,80GB GPU上處理30秒音頻并生成100個token時,batch size可達512,而同類模型在batch size 16時即顯存溢出。

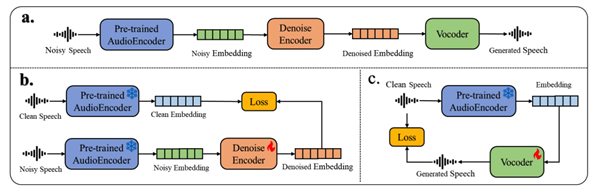

訓練范式革新:采用通用音頻描述對齊范式,通過非單調全局語義映射,學習音頻場景深層語義關聯,避免傳統ASR轉錄數據對齊的局限,數據利用率高,還能捕捉說話人情感、空間混響等關鍵聲學特征。