9月11日消息,據韓國媒體Thelec報導,韓國科學技術院(KAIST)電機工程系教授 Kim Joung-ho(在韓國媒體中被譽為“HBM 之父”)表示,高帶寬閃存(High Bandwidth Flash,HBF)有望成為下一代 AI 時代的重要存儲技術,將與高帶寬內存(HBM)并行發展,共同推動芯片大廠的業績成長。

HBF 的設計概念與 HBM 相似,均通過硅通孔(TSV)技術將多層芯片堆疊連接。 差別在于HBM以DRAM為核心,而HBF則采用NAND Flash閃存進行堆棧,具備“容量更大、成本更具優勢”的特點。

Kim Joung-ho指出,雖然NAND Flash的速度不及DRAM,但容量往往高出10倍以上,若以數百層乃至數千層堆疊方式構建,將能有效滿足AI模型對龐大儲存的需求,可望成為NAND Flash版本的HBM。

目前生成式 AI 模型正急速擴張,單一模型的輸入 Token 已達百萬級別,需要處理TB 級數據。 在每秒數千次的讀寫過程中,若存儲帶寬不足,就會出現瓶頸,導致 ChatGPT、Google Gemini 等大型語言模型(LLM)的反應速度明顯下降。

Kim Joung-ho 強調,這種限制來自現行的馮諾依曼架構,由于 GPU 與內存是分離設計,數據傳輸帶寬決定了效能上限,“即便將 GPU 規模擴大一倍,如果帶寬不足也毫無意義”。

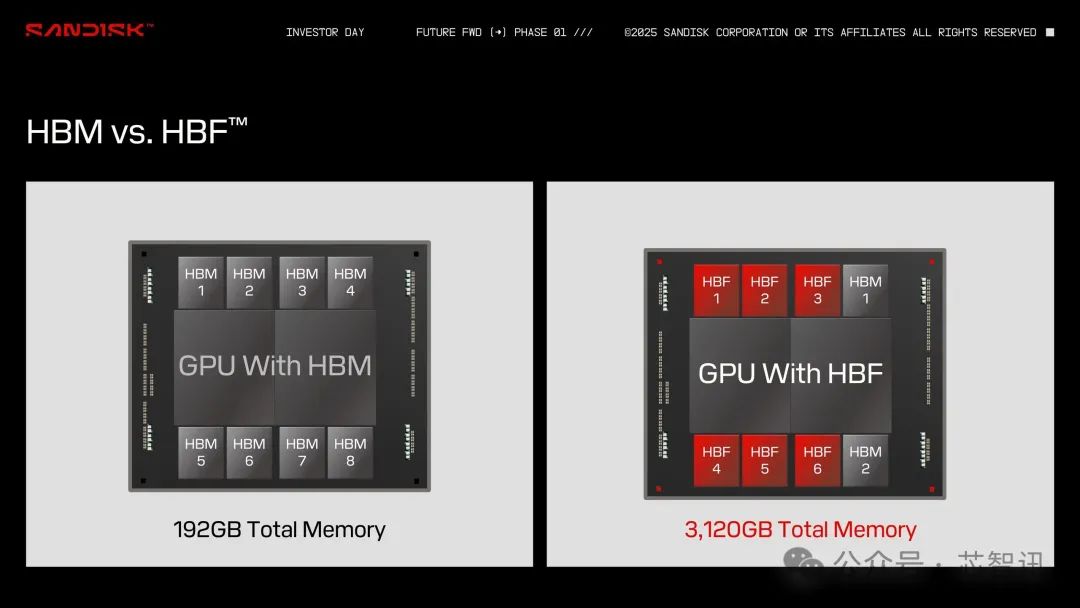

他預測,未來GPU將同時搭載HBM與HBF,形成互補架構:HBM做為高速快取,負責即時運算數據,而HBF則承擔大容量儲存,直接存放完整的AI模型。 這將有助于突破存儲瓶頸,使 GPU 能處理更龐大的生成式 AI,甚至涵蓋長篇視頻等復雜內容。 Kim Joung-ho 表示:“未來 AI 將不僅限于文字與圖像,而能生成如電影般的長片,屆時所需的內存容量將是現有的 1,000 倍以上。”

之前也有消息顯示,存儲芯片大廠Sandisk正在聯手SK海力士開發用于 AI 系統的HBF規范。HBF能夠以與DRAM型HBM相當的成本和帶寬,提供高達DRAM型HBM約8到16倍的容量。并且,與需要恒定功率來保存數據的 DRAM 不同,NAND 是非易失性的,因此能夠以更低的能耗實現持久存儲。

Sandisk 的目標是在 2026 年下半年交付其 HBF 閃存的第一批樣品,首款集成該技術的 AI 推理硬件預計將于 2027 年初推出。