摘 要: 邏輯模型樹(LMT)算法是基于樹歸納和邏輯回歸的一種分類算法。為驗證LMT算法的優勢,利用3個UCI標準數據集建模,將LMT算法與其他決策樹方法進行對比分析。針對LMT算法在建立邏輯回歸模型時會導致較高的計算復雜性的問題,研究利用赤池信息量準則改進LMT算法,提升算法時間性能,避免模型過度擬合。在UCI標準數據集和煙葉綜合質量評價數據中應用改進的LMT算法進行建模驗證,結果表明,該改進方法在模型精度和召回率方面基本優于其他決策樹方法,時間性能比改進前提升50%左右,能較好地評價煙葉綜合質量。

關鍵詞: 邏輯模型樹;UCI標準數據集;煙葉綜合質量評價數據;赤池信息量準則;模型精度;召回率

0 引言

決策樹分類法是一種簡單而廣泛使用的分類技術,是數據挖掘分類算法的一個重要方法,可以用于分析數據,同樣也可以用作預測。決策樹法作為一種決策技術,已被廣泛地應用于企業的投資決策之中,它是隨機決策模型中最常見、最普及的一種規策模式和方法,能有效地控制決策帶來的風險[1]。決策樹易于理解和實現,能同時處理數據型和常規屬性,能夠在相對短的時間內對大型數據源做出可行且效果良好的結果[2]。線性邏輯回歸和樹歸納是兩種常用的決策樹分類方法。但線性邏輯回歸在擬合簡單模型時會導致低方差和高偏差;而樹歸納會導致低偏差和高方差[3]。因此,將兩種分類方法相結合,提出邏輯模型樹方法,不僅能分類,而且能得到類概率估計, 能夠直接體現數據的特點,并且參數少,應用方便,模型準確度較高。

鑒于LMT算法的以上優點,研究將其應用在煙草企業煙葉綜合質量評價中。目前,在煙草企業中,煙葉的質量主要根據化學成分值和評吸專家的評吸來綜合判定。在判定過程中,各位專家要經過反復討論來判定每種煙葉的質量層次,以便煙草原料研究人員在配方使用前對煙葉進行初步篩選。為減少煙葉質量層次判定的討論時間,本文利用改進的LMT算法對煙葉數據進行建模并預測煙葉的質量層次。在實際應用中,提高了煙草原料研究人員的工作效率。

1 LMT算法基本原理

1.1 LMT簡介

LMT算法是由Niels Landwehr、Mark Hall 和 Eibe Frank在2003年第十四屆關于機器學習歐洲會議上提出的[4]。邏輯模型樹是由葉子上帶有邏輯回歸函數的標準決策樹結構構成的。這個方法采用LogitBoost算法在樹的節點上建立邏輯回歸函數[5],并使用CART算法進行剪枝[6]。本文利用AIC準則改進LMT算法[7],以減少決策樹的邏輯回歸模型的計算復雜度,從而減少訓練時間。

1.2 LogitBoost算法

Logitboost算法是改進的Boosting算法。其基本思想是:基于現有樣本數據集構建一個基礎的“弱分類器”,反復調用該“弱分類器”,通過對每輪中錯判的樣本賦予更大的權重,使其更關注那些難判的樣本,經過多輪循環,最后采用加權的方法將各輪的“弱分類器”合成“強分類器”,從而得到較高精度的預測模型[8]。

1.3 CART算法

CART算法選擇具有最小基尼指數值的屬性作為測試屬性, 并采用一種二分遞歸分割技術, 將當前樣本集分為兩個子樣本集, 使得生成的決策樹的每一個非葉節點都有兩個分枝。最后生成的決策樹是結構簡潔的二叉樹,用獨立的驗證數據集對訓練集生長的樹進行剪枝,不易產生數據碎片。CART剪枝算法使用獨立于訓練樣本集的測試樣本集對子樹的分類錯誤進行計算, 找出分類錯誤最小的子樹作為最終的分類模型[9]。

1.4 LMT算法步驟

LMT算法步驟描述如下:

⑴ 建立根節點;

⑵ 建立邏輯模型樹:

① 初始化

權重Wij=1/n,i=1,…,n,j=1,…,J

分類器Fj(x)=0;概率估計pj(x)=1/J

② 利用五折交叉驗證得到最佳迭代次數M

③ 進行迭代, m=1,…,M

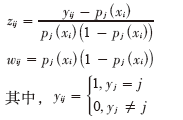

a.分別計算作業應變量和權重

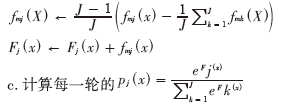

b.采用加權最小二乘法擬合弱分類器函數fmj(X) :

c.計算每一輪的

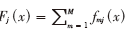

④ 輸出最終的分類器 ,根據正負對樣品判別歸類;

,根據正負對樣品判別歸類;

⑶ 繼續分裂樣本,并對分裂樣本的數據子集再重復步驟⑵建樹,直至停止分裂;

⑷ 利用CART算法對其進行修剪。

1.5 AIC準則

本研究中使用泛化誤差的樣本內估計赤池信息量準則來替換原算法中交叉驗證選取最佳迭代次數來改進LMT算法[10]。赤池信息量準則(Akaike Information Criterion),又稱為AIC準則。赤池建議,當欲從一組可供選擇的模型中選擇一個最佳模型時,可選擇AIC為最小的模型。赤池信息量準則的方法是尋找可以最好地解釋數據但包含最少自由參數的模型[11]。

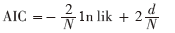

AIC提供了當使用可能性損失函數時的泛化誤差估計,其定義為:

missing image file

其中,d是迭代次數,lik為模型的極大似然函數,N是訓練實例個數。隨著d的增長,等式的第一項下降(因為LogitBoost完成擬牛頓算法,接近最大似然函數對數),第二項總是會增加。因此,選最佳迭代次數是最小化AIC時的迭代次數d。

使用AIC標準來防止模型過度擬合,訓練時間比原LMT算法快很多[7]。研究中默認AIC最小迭代是50次。

2 實驗分析

2.1 分析環境

研究利用Weka軟件對數據進行建模。Weka的全名是懷卡托智能分析環境,是一款免費的、非商業化的、基于JAVA環境的開源機器學習以及數據挖掘軟件。Weka作為一個公開的數據挖掘工作平臺,集合了大量能承擔數據挖掘任務的機器學習算法,包括對數據進行預處理、分類、回歸、聚類、關聯規則以及在新的交互式界面上的可視化[12]。

2.2 數據描述

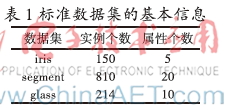

UCI標準數據集:UCI數據庫是加州大學歐文分校提出的用于機器學習的數據庫,這個數據庫目前共有187個數據集,其數目還在不斷增加,UCI數據集是一個常用的標準測試數據集,從中挑選iris、segment、glass三個標準數據集進行建模預測。

煙葉數據:該煙葉實驗數據由全國各省不同等級的入庫煙葉組成,包括產地、等級、質量層次、各化學成分值和各感官評價分數等,其中質量層次數據是各位專家根據經驗和評吸情況通過共同討論綜合決定的。實驗中,訓練建模數據選擇全國各省數據355條,測試數據分別選擇云南省上部煙數據16條、云南省中部煙數據28條。

2.3 實驗步驟

針對UCI標準數據集,分別用LMT算法及其他決策樹對比算法建模,對結果進行比較分析,然后用改進的LMT算法對數據集進行建模,與原LMT算法結果進行對比分析。

針對煙葉數據,首先剔除含有缺失值的煙葉,然后對輸出屬性數據即質量層次數據進行離散化,由于有多種描述煙葉各方面的指標,本研究通過特征指標選擇,選取施木克值、總糖、雜氣、香氣質、余味、香氣量、刺激性、濕潤程度作為建模特征指標數據,最后利用改進的LMT算法對其建模預測,并分析結果。

2.4 實驗驗證

實驗一:不同的算法在UCI標準數據集中的結果

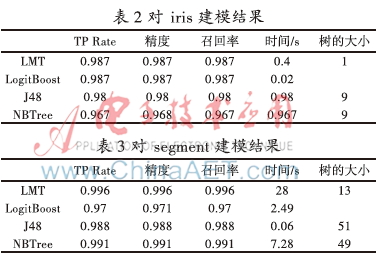

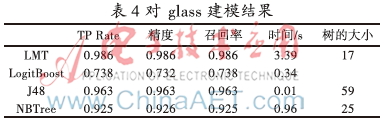

取iris、segment、glass 3個不同的標準數據集,數據集的信息如表1所示。對3個標準數據集分別用LMT、Logistic、J48、NBTree 4種算法進行建模分類,其性能結果分別如表2、表3、表4所示。

從表2、表3、表4中可以看出,LMT算法的TP Rate、精度、召回率均比LogitBoost、J48、NBTree算法高,而且LMT建模的樹規模最小,說明LMT算法在保證建模準確率的前提下,通過邏輯模型使樹更易被解釋,但缺點是由于計算復雜度高導致耗時過長。針對這一問題,利用AIC準則對LMT算法改進,提高時間性能。

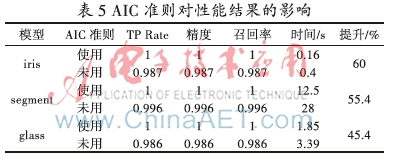

實驗二: AIC準則對LMT算法的影響

針對3個UCI標準數據集,使用AIC準則和不使用AIC準則分別進行建模,其性能結果如表5所示。

從表5中可以看出,使用AIC準則后,對3個數據集進行建模,TP Rate、精度、召回率、時間性能均有不同幅度的提升,說明使用AIC準則可以對LMT算法進行有效的改進。

實驗三:利用改進的LMT算法對煙葉數據進行建模預測

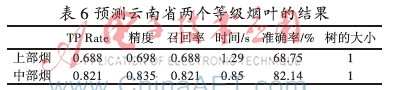

先用NBTree算法對355條全國各省不同等級煙葉的化學成分數據和評吸質量分數來建模,模型的精度和時間性能結果并不理想。再用改進的LMT算法對煙葉數據建模,然后利用模型分別將16條云南省上部煙數據、28條云南省中部煙數據對各煙葉的質量層次進行預測,其結果如表6所示。

從表6中可以看出,改進的LMT算法對云南省的兩個部位的煙葉預測結果較為理想。由于質量層次數據是由專家討論綜合決定,存在一定的人為因素,所以準確率較標準數據集略低,但在實際應用中,該算法建模預測能較好地評價煙葉綜合質量。因為中部煙數據量多,建立的模型更加完備,因此預測較上部煙更為準確。

3 結束語

本文介紹了LMT算法的基本原理,針對LMT算法的時間性能問題,利用AIC準則通過改進選取最佳迭代次數的方式,使時間性能大幅度提升。通過對比LMT算法與其他算法對標準數據集建模的結果發現,LMT算法在模型精度上優于其他算法,模型精度高,結果易于解釋,并且改進的LMT算法使時間性能提升50%左右。使用改進的LMT算法對煙葉數據建模預測,結果表明改進的LMT算法對模型的準確率有相應的提高,而且能夠有效地提高時間性能。實驗表明改進的LMT算法較其他算法更適用于評價煙葉綜合質量。該模型在企業實際應用的結果表明,可以在入庫片煙質量評價過程中快速、有效地依據化學成分和感官指標判定煙葉的綜合質量,減少專家評吸次數,并且為原料在不同檔次卷煙配方中的可用性提供信息支撐。

參考文獻

[1] 田苗苗. 數據挖掘之決策樹方法概述[J]. 長春大學學報, 2005,14(6): 48-51.

[2] 陳誠. 基于AFS理論的模糊分類器設計[D]. 大連:大連理工大學, 2009.

[3] Perlich C, Provost F, Simonoff J S. Tree induction vs. logistic regression: a learning-curve analysis[J]. The Journal of Machine Learning Research, 2003, (4): 211-255.

[4] Landwehr N, Hall M, Frank E. Logistic model trees[J]. Machine Learning, 2005, 59(1/2):161-205.

[5] Friedman J, Hastie T, Tibshirani R. Special invited paper. additive logistic regression: A statistical view of boosting[J]. Annals of statistics, 2000,28(2): 337-374.

[6] Breiman L, Friedman H, Olshen J A. Classification and Regression Trees[M]. New York:Wadsworth,1984.

[7] Sumner M, Frank E, Hall M. Speeding up logistic model tree induction[M].Knowledge Discovery in Databases: PKDD 2005, Springer Berlin Heidelberg, 2005.

[8] 富春楓,荀鵬程,趙楊,等. logitboost 及其在判別分析中的應用[J]. 中國衛生統計, 2006,23(2):98-100.

[9] 季桂樹,陳沛玲,宋航. 決策樹分類算法研究綜述[J]. 科技廣場, 2007(1):9-12.

[10] Akaike H. Information theory and an extension of the maximum likelihood principle[M].Breakthroughs in statistics, Springer New York, 1992.

[11] De Ridder F, Pintelon R, Schoukens J, et al. Modified AIC and MDL model selection criteria for short data records[J]. Instrumentation and Measurement, IEEE Transactions on, 2005, 54(1): 144-150.

[12] 陸遠蓉. 使用數據挖掘工具Weka[J]. 電腦知識與技術, 2008,1(6):988-993.